在大语言模型(LLM)狂飙突进的当下,参数量似乎已经成了衡量智能的唯一标尺。然而,技术界正涌动着另一股不可忽视的力量——小语言模型(Small Language Models, SLMs)。

SLM 并不是大模型的「缩水版」,而是针对特定场景的「精锐特种兵」。它们能在资源受限的环境中,以极低的算力成本,实现惊人的自然语言处理能力。

01. 什么是小语言模型(SLM)

小语言模型(SLM)是一种轻量级的计算模型,具备理解和生成自然语言的核心能力。跟动辄千亿参数的大语言模型(LLM)不同,SLM 旨在通过精简的架构和更少的参数,以极高的效率来完成特定任务。

如果说 LLM 是通晓万物的「百科全书」,那么 SLM 就是一本案头必备的「专业实操手册」。它们保留了 Transformer 架构的核心优势,却能在本地设备上流畅运行,还不需要昂贵的服务器集群支持。

1.1 技术架构解析

SLM 的核心构建逻辑在于「做减法」:

- 精简的神经网络:SLM 采用了 LLM 中神经网络的简化版本。LLM(比如 GPT-4)的参数量通常达到万亿级别,而 SLM 的参数量通常会控制在几百万到几十亿之间。

- 高效的参数设置:参数不仅决定了模型的「脑容量」,也决定了计算的复杂度。SLM 通过大幅削减参数规模,在算力消耗和响应速度上,实现了质的飞跃。

- 核心组件:

- 词嵌入:将文本转化为计算机可以理解的「数值向量」,捕捉词汇的语义。

- Transformer 引擎:利用编码器(Encoder)处理输入信息,解码器(Decoder)生成文本响应。

1.2 训练机制:少而精

在训练 SLM 时,其实并不追求数据的「大而全」,而是专注于「少而精」。

- 数据集:SLM 使用的文本语料库比 LLM 更小,但会经过严格筛选,更具专业性。

- 微调:基础模型训练完成后,开发者会针对特定任务(如医疗咨询、代码补全)进行微调,让它在垂直领域的表现更加出色。

02. 为什么我们需要 SLM?

在实际部署中,SLM 展现出了 LLM 无法比拟的战术优势:

2.1 极致的资源效率

- 低算力门槛:SLM 不需要昂贵的 GPU 集群,甚至可以在中端笔记本或手机上运行。

- 绿色节能:能耗大幅降低,不仅减少了电力成本,也更符合环境的可持续发展要求。

2.2 敏捷的开发周期

- 快速迭代:小语言模型的训练时间极短,研发团队可以快速试错、验证想法,加速产品上线流程。

- 低成本试错:显著降低了算力和时间成本,让中小企业和个人开发者也能负担得起 AI 开发。

2.3 边缘计算的王者

- 本地运行:得益于紧凑的体积,SLM 可直接部署在边缘设备上,无需依赖云端连接。

- 隐私安全:数据无需上传云端,所有处理都在本地完成,极大提升了用户数据的安全性。

2.4 垂直领域的专家

- 专业精度:虽然通用能力不如 LLM,但在经过特定领域的数据微调后,SLM 在专业任务上的准确率往往能反超通用大模型。

03. SLM 的挑战与局限

SLM 的设计哲学是「以空间换时间,以泛化换精度」,这也注定了它存在「先天短板」:

- 复杂理解力不足:如果说 LLM 阅读过整个人类图书馆,SLM 可能只读过几本专业书。面对需要跨领域知识、深层逻辑推理或极度抽象的复杂任务时,SLM 容易捉襟见肘,甚至产生误解。

- 推理深度的天花板:在多步推理、复杂决策或处理错综数据模式时,受限于参数规模,SLM 的容错率和精确度通常要低于 LLM。

- 深层学习能力的局限:对于需要极高算力支撑的深度学习应用,SLM 并不是最佳选择。开发者需在性能与效率之间做出权衡。

04. SLM 的三大流派

根据构建方式的不同,目前的 SLM 主要分为三类:

4.1 蒸馏模型(Distilled Models)

「名师出高徒」的技术体现。

- 原理:利用一个巨大的「教师模型」来训练一个较小的「学生模型」。学生模型通过模仿教师的输出分布,学习其知识精华。

- 代表作:DistilBERT。它保留了 BERT 的绝大部分的性能,但体积缩小了 40%,速度提升了 60%。

4.2 任务特定模型(Task-specific Models)

「术业有专攻」的极致。

- 原理:不追求通用聊天能力,而是针对情感分析、机器翻译或问答系统进行深度定制。

- 优势:在特定赛道上,其表现往往会优于通用的 ChatGPT、DeepSeek 等大模型。

4.3 轻量化模型(Lightweight Models)

为移动端而生的「原生轻量级选手」。

- 原理:从架构设计之初就以移动应用和边缘设备为目标,极致优化参数结构。

05. 落地场景:SLM 在哪里发光?

SLM 的特性让它在以下场景中无可替代:

- 端侧智能:在智能手机、智能音箱上运行语音识别、预测性输入和离线翻译。核心价值在于零延迟、零流量消耗,以及数据的绝对隐私。

- 实时交互系统:客服机器人、实时字幕生成等对延迟极其敏感的应用。核心价值在于毫秒级的响应速度,提供流畅的用户体验。

- 资源受限环境:IoT 设备、偏远地区的基础设施。核心价值在于,即使在廉价硬件上也能跑通 AI 逻辑,大幅降低了智能化普及的门槛。

06. 趋势前瞻:SLM 的下一步

随着技术的演进,SLM 也正变得越来越「聪明」且「强壮」:

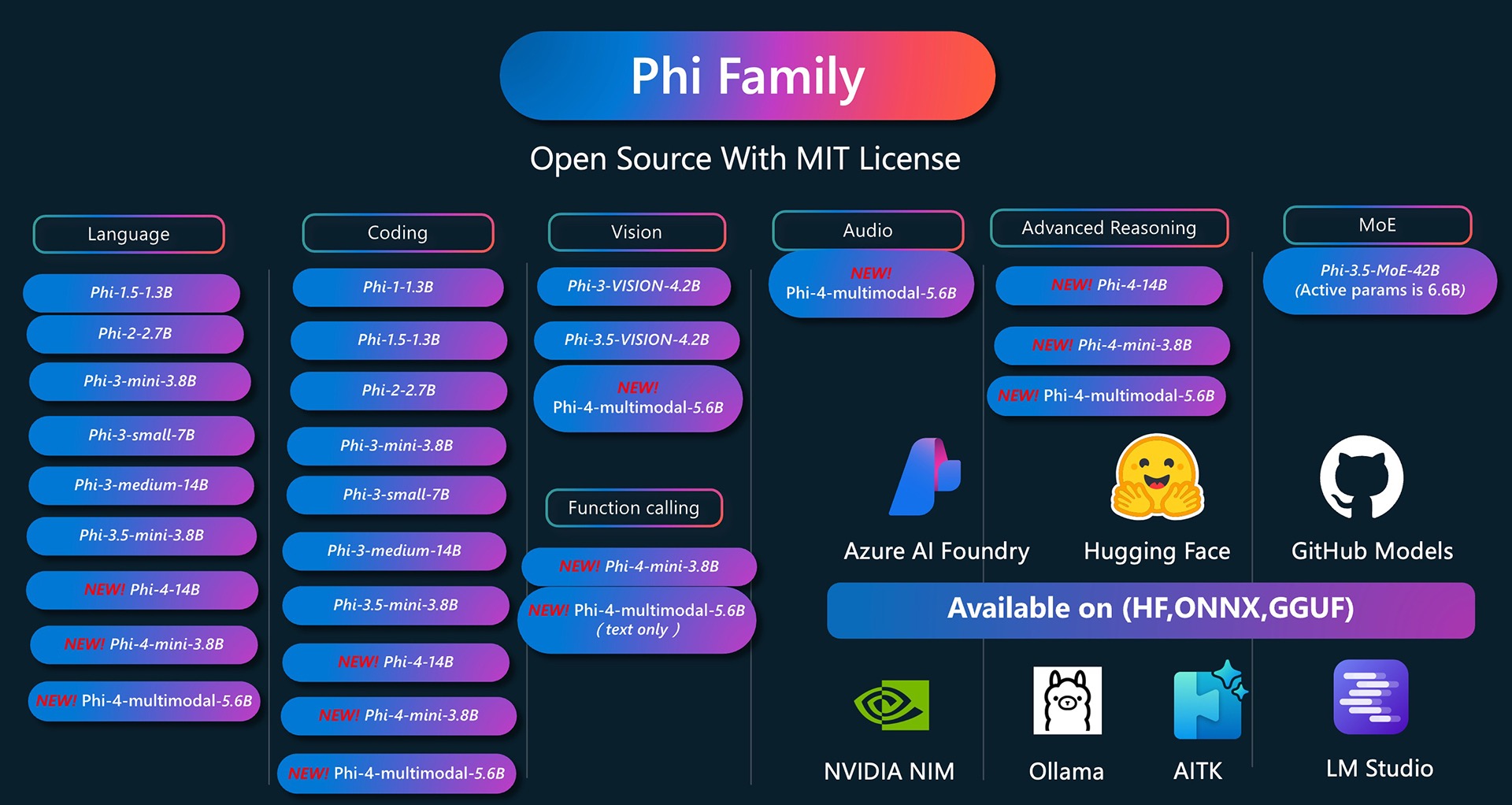

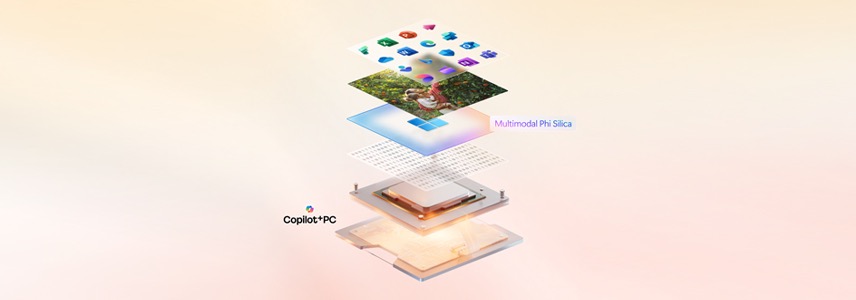

- 模型压缩技术的突破:通过量化(Quantization)和剪枝(Pruning)技术,未来的 SLM 将在保持体积不变的情况下,承载更复杂的逻辑。例如微软的 Phi-4 系列,已经开始引入计算机视觉能力,走向多模态。

- 边缘计算的爆发:随着 AI PC 和 AI 手机的普及,SLM 将成为设备自带的「大脑」,实现情境感知的本地智能。

- 联邦学习:这是一种颠覆性的训练方式。模型可以在多个用户的设备上分别训练,仅共享学习到的参数更新,而不共享原始数据。这让 SLM 能在保护隐私的前提下,利用全网数据持续进化。

总的来说,AI 的未来不仅仅是建造更大的「超级大脑」,同样也包括将智能赋予每一台微小的终端。小语言模型(SLM)正是这场「智能下沉」革命的先锋。

最新评论

chmod +x之前一定要先把目录cd到安装文件所在的文件夹直接chmod有时不起作用

开dlna后,文件导入真的看不到怎弄

并不完全相同

是不是和KB5077241更新日志重复了