AI 有望解决人类面临的一些紧迫问题,但前提是每个人都能获得必要的工具来构建解决方案。基于这一理念,Google 今年早些时候发布了 Gemma:一系列轻量级且技术先进的开源模型,它们采用了与 Gemini 模型相同的研究成果和技术。同时,还扩展了 Gemma 产品线,新增了 CodeGemma、RecurrentGemma 和 PaliGemma,每种模型都针对不同的 AI 任务提供特定功能,并可通过与 Hugging Face、NVIDIA 和 Ollama 等集成,来轻松使用。

现在,Google 正式向全球研究人员和开发者发布了 Gemma 2。它提供了 90 亿(9B)和 270 亿(27B)两种参数规模,不仅性能更强,推理效率更高,安全性也显著提升。尤其是 27B 参数的版本,能与规模超过其两倍的模型相媲美,达到了此前只有专有模型才能实现的性能水平。更令人兴奋的是,这样的高性能现在只需一块 NVIDIA H100 Tensor Core GPU 或一台 TPU 主机就能实现,大大降低了部署成本。

Gemma 2:效率与性能的完美平衡

Gemma 2 采用全新架构设计,旨在实现卓越的性能和高效的推理。以下是 Gemma 2 的几大亮点:

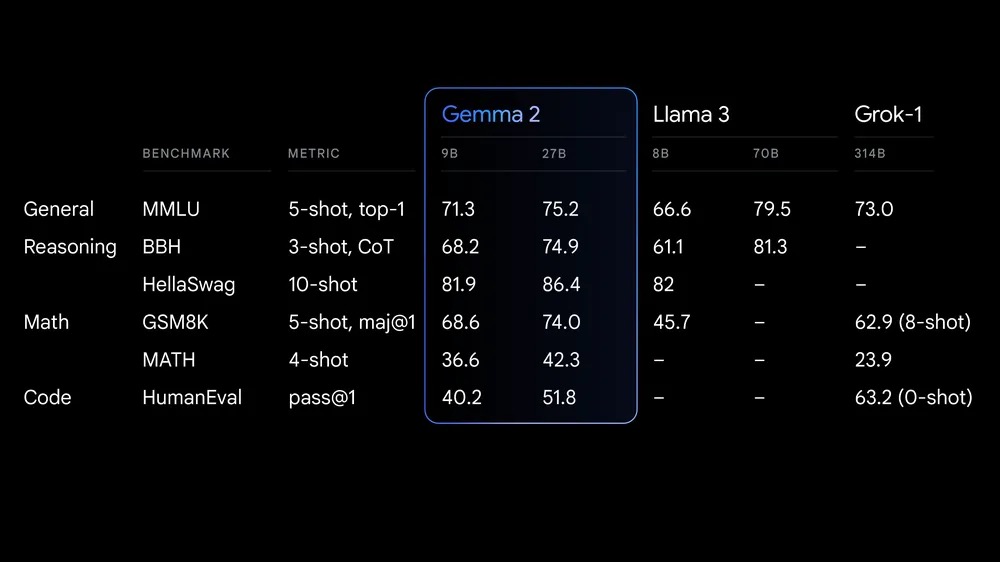

- 性能出色:27B 参数的 Gemma 2 在同类产品中表现领先,甚至能与参数量翻倍的模型一较高下;9B 参数版本同样不俗,超越了 Llama 3 8B 等同类开源模型。详细对比数据请查看技术报告。

- 高效低成本:27B 参数的 Gemma 2 只需单个 Google Cloud TPU 主机、NVIDIA A100 80GB Tensor Core GPU 或 NVIDIA H100 Tensor Core GPU 就能全精度运行。大幅降低了成本,同时保持了高性能,让 AI 部署更经济实惠、更易落地。

- 全面硬件兼容,推理超快:Gemma 2 针对各类硬件进行了速度优化,从游戏本到高端台式机,再到云端设备,都能高效运行。你可以在 Google AI Studio 中体验全精度的 Gemma 2,用 Gemma.cpp 在 CPU 上发挥本地性能,或通过 Hugging Face Transformers 在家用电脑上借助 NVIDIA RTX 或 GeForce RTX 显卡来尝鲜。

Gemma 2:为开发者和研究人员量身打造

Gemma 2 不仅性能更强,还专门进行了设计,能够更好地融入你的工作流程:

- 开放易用:与上代 Gemma 一样,Gemma 2 采用商业友好的 Gemma 许可证,让开发者和研究人员能自由分享和商用自己的创新成果。

- 广泛的框架支持:Gemma 2 支持主流 AI 框架,包括 Hugging Face Transformers、JAX、PyTorch 和 TensorFlow。通过 Keras 3.0、vLLM、Gemma.cpp、Llama.cpp 和 Ollama 等原生工具,你可以轻松将其融入喜欢的工具链和工作流程。此外,Gemma 已通过 NVIDIA TensorRT-LLM 优化,可在 NVIDIA 加速的基础设施上运行,或作为 NVIDIA NIM 推理微服务使用,未来还将支持 NVIDIA NeMo。现在你就可以用 Keras 和 Hugging Face 进行微调,Google 也在积极开发更多高效的微调方案。

- 部署无忧:2024 年 8 月起,Google Cloud 用户就可以在 Vertex AI 上轻松部署和管理 Gemma 2。

Google 还推出了全新的 Gemma Cookbook,这是一个实用示例和方法集锦,帮助你构建自己的应用,并针对特定任务微调 Gemma 2 模型。你可以学习如何轻松地将 Gemma 与所选择的工具结合使用,包括检索增强生成等常见任务的实现方法。

Gemma 2:负责任的 AI 发展

Google 致力于为开发者和研究人员提供必要资源,帮助他们负责任地构建和部署 AI 技术。这包括「负责任生成式 AI 工具包」和最近开源的大语言模型比较器(LLM Comparator),就是为了帮助开发者和研究人员深入评估语言模型。现在,你可以使用相应的 Python 库进行模型比较评估,并通过应用程序直观展示结果。同时,Google 正在开源适用于 Gemma 模型的文本水印技术 SynthID。

在训练 Gemma 2 的过程中,Google 遵循了严格的内部安全流程:

- 筛选预训练数据

- 通过一系列全面的指标进行严格测试和评估,以识别和减少潜在偏见和风险

- 在多个与安全性和代表性伤害相关的公共基准测试中发布了研究成果

使用 Gemma 构建的项目

自 Gemma 首次推出以来,下载量已超过 1000 万次,催生了众多富有创意的项目。比如,Navarasa 项目就利用 Gemma 打造了一个展现印度语言多样性的模型。

现在,Gemma 2 将为开发者带来更强大的性能和潜力,助力其实现更具雄心的项目。Google 将持续研究新架构,并开发针对性的 Gemma 变体,以应对更多 AI 任务和挑战。

即将推出的 2.6B 参数 Gemma 2 模型,专门设计用于平衡轻量化和高性能。该版本将为那些需要在有限资源下获得优秀性能的场景提供支持。

你可以通过技术报告了解更多即将发布的详情。

快速上手 Gemma 2

Gemma 2 现已在 Google AI Studio 上线。你可以直接体验 27B 参数版本的全部性能,无需特殊硬件。此外,你还可以从以下渠道获取 Gemma 2 的模型权重:

为了支持研究和开发,Google 还提供了以下便利:

- Kaggle 上免费使用 Gemma 2

- Colab 笔记本中的免费额度

- 首次使用 Google Cloud 的用户可能有资格获得 300 美元的信用额度

对于学术研究人员,Google 还特别推出了 Gemma 2 学术研究计划。通过该计划,你可以获得 Google Cloud 信用额度,来加速你的 Gemma 2 研究。申请通道现已开放,截止日期为 2024 年 8 月 9 日。

最新评论

如果是刷BIOS的u盘可以看看bios里防覆写保护关没关

26100 IoT为什么LTSC好几个版本的补丁都是安装不上

我推荐使用GXDE系统,内有火星应用商店。

服务器应该没有“滚动更新”的需求吧,不过Canonical 倒是方便我们这些爱好者折腾了