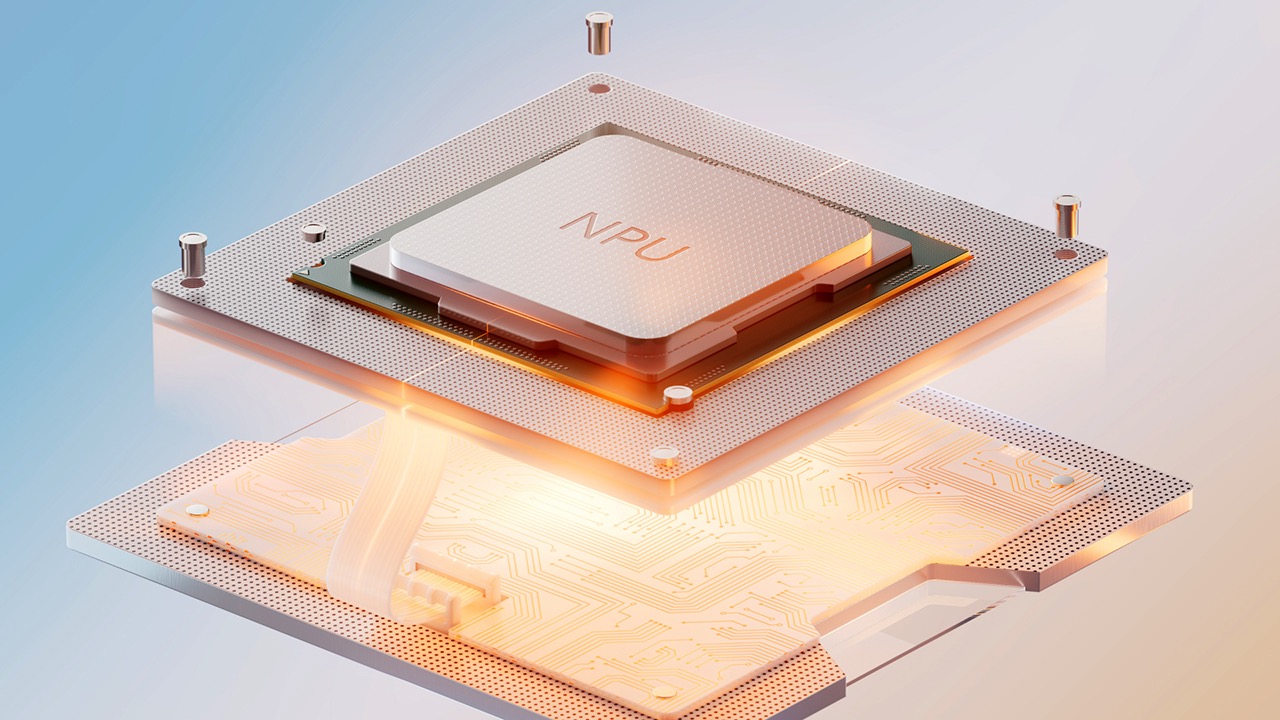

生成式 AI 正在席卷全球。从智能手机到电脑,乃至未来的各种数字设备,AI 几乎无处不在。AI 的广泛应用需要强大的算力,而传统的 CPU 和 GPU 已经越来越难以胜任。于是,NPU(神经处理单元)应运而生。

现在,像三星 Galaxy S22、S23 和 S24 等旗舰智能手机已经开始搭载 NPU。不过,NPU 要在个人电脑中普及还需要一些时间。Intel 和 AMD 等芯片巨头已经开始推出集成 NPU 的处理器,如 Intel 的 Meteor Lake、Core 和 Core Ultra 系列,以及 AMD 的 Ryzen 8040 系列等。

那么,NPU 到底是什么?我们真的需要 NPU 吗?本文将为你详细解读 NPU 技术,帮助你了解它的定义和用途等。

NPU 是什么?

简单来说,NPU 是一种专门用于处理机器学习算法的处理器。它能够比传统 CPU 和 GPU 更快地执行复杂的数学运算,这对于高效运行神经网络至关重要。

NPU 主要用于处理涉及大量小规模并行计算的 AI 任务。它在处理图片、视频等多媒体数据和神经网络数据时表现出色,因为这些处理器天生就是为了并行计算而设计的。

虽然 CPU 和 GPU 也能处理机器学习任务,但效率远不如 NPU。此外,在设备中集成 NPU 可以大大减轻 CPU 和 GPU 的负担,让它们能够更专注地执行其他任务。

NPU 在功能和外观上与特定应用集成电路(ASIC)类似,但两者并不相同。NPU 设计更为复杂和多功能,可以满足各种神经网络计算需求;而 ASIC 通常只针对单一用途(如加密货币挖矿)。NPU 的强大能力来自于专门为神经网络计算而设计的硬件、软件、编程和驱动。

值得一提的是,Google 也推出了自家的 AI 处理器,称为 TPU(张量处理单元)。虽然 TPU 的架构与 NPU 不同,但同样专注于处理复杂的 AI 算法。

NPU、CPU 和 GPU 有什么不同?

在 AI 计算中,需要执行大量的「乘加运算」(Multiply Accumulate, MAC)。大多数 AI 算法都是由许多这样的运算构成,它们在大数据集上往往形成树状结构,更适合分批处理较小的计算任务。这正是 NPU 的强项。

- CPU 则是执行多种任务的系统核心。

- GPU 则主要用于并行处理大型数据集,如图像和视频处理。

- 相比之下,NPU 设计之初就是为了快速完成较小的计算任务。专门用于加速深度学习算法,因此在处理 AI 相关任务时,性能远超 CPU 和 GPU。

虽然 GPU 和 CPU 也能执行 AI 计算,但 NPU 能将这些计算分解成更小的部分,从而实现更快速的处理。

推荐阅读:NPU 与 GPU 有什么区别?

NPU 与 TPU

Google 开发的 TPU 同样专注于处理神经网络,与 NPU 功能相似。但它们在架构上有显著的不同。

与采用传统冯·诺依曼架构(将内存和处理单元分离)的 NPU 不同,TPU 采用了一种名为脉动阵列(Systolic Array)的特殊设计,将运算处理和内存单元合并在一个芯片上。因此,TPU 在进行并行计算时,能比 NPU 更快、更高效。

目前,TPU 只在 Google 的 Pixel 手机和 Google Cloud 云平台上提供,随着版本迭代,每一代的性能都会有所提升。

虽然 NPU 在峰值性能上要优于 TPU,但它们的能耗和延迟也更高;相比之下,TPU 的峰值性能稍低,但能耗更低,延迟也较小。

什么是 GPNPU?

GPNPU 并不是 GPU + NPU 的结合体,而是代表「通用神经处理单元」(General Purpose Neural Processing Units)。

GPNPU 采用了统一处理器架构的单一执行管道,能够处理向量和矩阵运算,以及标量(控制)代码。由于整个设计只有一个由软件控制的核心,因此可以更轻松地处理复杂的并行工作负载。

NPU 是未来趋势吗?

AI 正在逐渐成为主流技术。就以 Windows 11 为例,几乎每个月都会推出新的 AI 功能。最近,微软在「照片」应用中添加了「生成式擦除」这一 AI 功能。此前,还推出了包括 Copilot 在内的多项 AI 功能。此外,越来越多的应用和服务也开始整合 AI 技术。因此可以预见,AI 将很快渗透到我们生活的方方面面。

对于深度 AI 用户来说,NPU 是一种非常有价值的硬件投资。如前所述,NPU 能显著提升设备的处理能力。基于现有趋势,NPU 将被广泛应用于日常使用的现代设备当中,未来甚至可能成为物联网(IoT)设备的标配。

我需要 NPU 吗?

目前市场上的大多数 AI 服务,如 OpenAI 的 ChatGPT 语言模型,都在云端进行计算。那为什么还需要本地 NPU 呢?

- 使用本地 NPU 的一个主要优势是可以显著减少数据在 Intelnet 和本地之间返回的延迟。因此,如果你的工作高度依赖 AI,那么拥有专属的 NPU 将大大提高处理速度。

- 此外,NPU 还可以减轻 CPU 和 GPU 的负担,让它们可以空出资源来处理其他重要任务。如果你的系统搭载了 NPU,你就能将 CPU 和 GPU 留给其他需要大量硬件资源的任务。

- 最后,如果你是 Windows 11 用户,很多 24H2 及更高版本中的 AI 功能都需要满足 AI PC 或 Copilot+ PC 条件的设备才能使用,例如 Windows Recall 和 Windows Studio Effects 等。

综上所述,如果你频繁进行以 AI 为核心的计算任务,那么拥有 NPU 将非常有价值。

最新评论

你当前登录的用户不是管理员账户(没在administrators组中)?

奇怪,为啥我已经右键以管理员运行uup_download_windows了cmd里还提示我需要管理员权限运行

valeo@DESKTOP-BHEH91Q:~$ sudo systemctl is-active docker System has not been booted with systemd as init system (PID 1). Can't operate. Failed to connect to bus: Host is down 这个问题怎么解呀各路大神

Win11更改任务栏为顶部,把03改成01操作后没变化,在此操作发现注册表又还原回为03。 也就是说改注册表也是改不了,不知道为什么WIN11要把这个功能去掉,又影响了什么,一个系统升级改来改去。